SÄ°ZÄ°N web sitenizde yapay zekayÄą 60 saniyede

Yapay zekamÄązÄąn web sitenizi anÄąnda nasÄąl analiz ettiÄini ve kiÅiselleÅtirilmiÅ bir sohbet robotu oluÅturduÄunu gÃķrÞn - kayÄąt olmadan. Sadece URL'nizi girin ve nasÄąl çalÄąÅtÄąÄÄąnÄą izleyin!

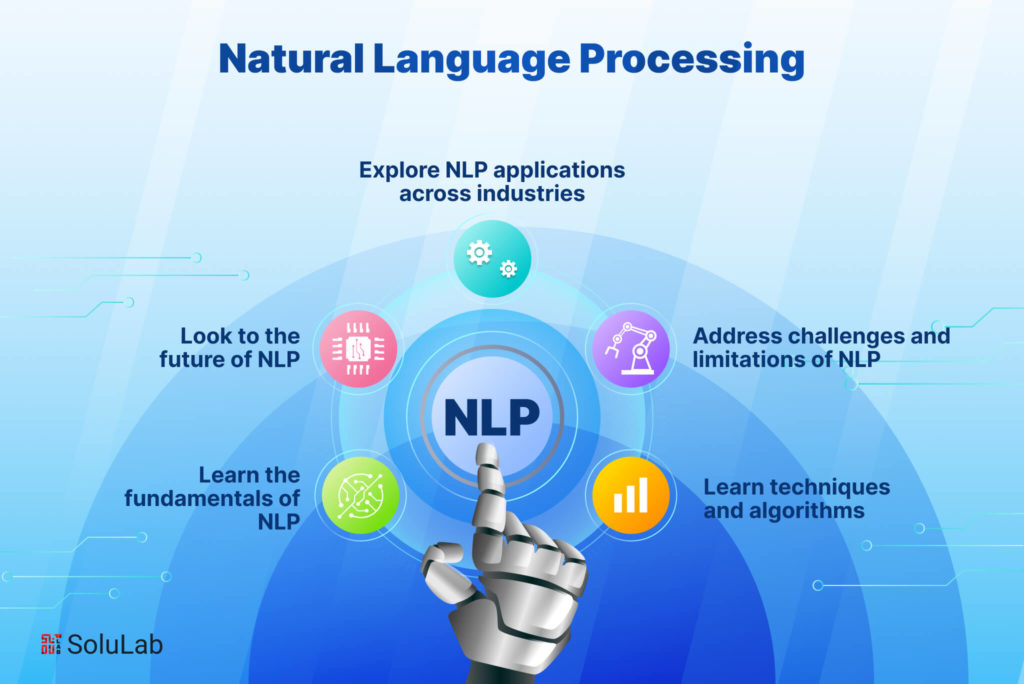

GiriÅ: NLP GeliÅiminin GeliÅen ManzarasÄą

GeçtiÄimiz yÄąl, daha verimli ince ayar yaklaÅÄąmlarÄąndan metni diÄer veri tÞrleriyle birleÅtiren çok modlu yeteneklere kadar NLP teknolojisinde dikkate deÄer ilerlemeler gÃķrÞldÞ. Daha fazla NLP iÅ yÞkÞ uç cihazlara ve tÞketici donanÄąmlarÄąna geçtikçe çalÄąÅma zamanÄą verimliliÄi giderek daha Ãķnemli hale geldi. Bu arada, uzmanlaÅmÄąÅ alan yetenekleri saÄlÄąk hizmetlerinden hukuk hizmetlerine kadar sektÃķrlere benzeri gÃķrÞlmemiÅ bir doÄrulukla hizmet etmek Þzere geniÅledi.

Ä°ster bir konuÅma aracÄąsÄą oluÅturun, ister mÞÅteri geri bildirimlerini analiz edin, ister belgelerden içgÃķrÞler Ã§ÄąkarÄąn veya içerik oluÅturma araçlarÄą oluÅturun, doÄru NLP kitaplÄąÄÄąnÄą seçmek projenizin baÅarÄąsÄąnÄą Ãķnemli ÃķlçÞde etkileyebilir. Bu kÄąlavuz, 2025'in en etkili yedi NLP kitaplÄąÄÄąnÄą inceleyerek, bir sonraki geliÅtirme projeniz için bilinçli bir karar vermenize yardÄąmcÄą olmak için gÞçlÞ yÃķnlerini, sÄąnÄąrlamalarÄąnÄą ve ideal kullanÄąm durumlarÄąnÄą karÅÄąlaÅtÄąrÄąr.

1. Hugging Face Transformers 6.0: KapsamlÄą Ekosistem

Temel Ãzellikler ve Ä°yileÅtirmeler

En son sÞrÞm, birkaç oyun deÄiÅtirici Ãķzellik sunuyor:

Verimli Ä°nce Ayar Ãerçevesi: Yeni EFT modÞlÞ, temel modelleri belirli gÃķrevlere uyarlamak için hesaplama gereksinimlerini Ãķnemli ÃķlçÞde azaltÄąr. Daha Ãķnce ince ayar için birden fazla GPU gerektiren modeller artÄąk minimum performans ÃķdÞnleriyle tÞketici donanÄąmÄąnda ÃķzelleÅtirilebilir.

Ãok Modlu Boru HatlarÄą: Transformers artÄąk metin analizini gÃķrÞntÞ, ses ve hatta video anlayÄąÅÄąyla sorunsuz bir Åekilde birleÅtiren uygulamalar oluÅturmak için akÄącÄą boru hatlarÄą sunuyor; daha baÄlam farkÄąnda uygulamalar oluÅturmak için mÞkemmel.

Kurumsal DÞzeyde DaÄÄątÄąm AraçlarÄą: Yeni daÄÄątÄąm araç seti, sunucu kÞmelerinden mobil cihazlara kadar farklÄą donanÄąm hedefleri için otomatik optimizasyonla modelleri araÅtÄąrmadan Þretime taÅÄąmayÄą basitleÅtirir.

Alan UzmanlÄąk Paketleri: SaÄlÄąk, hukuk ve finans gibi belirli sektÃķrler için Ãķnceden yapÄąlandÄąrÄąlmÄąÅ ayarlar ve modeller, geliÅtiricilerin genel modeller yerine alan için optimize edilmiÅ temellerle baÅlamalarÄąna olanak tanÄąr.

GeliÅtiricilerin Neden SevdiÄi

Transformers, eriÅilebilirlik ve son teknoloji yetenekler arasÄąnda olaÄanÞstÞ bir denge saÄladÄąÄÄą için hakimiyetini sÞrdÞrÞyor. Ä°yi belgelenmiÅ API, yeni baÅlayanlarÄąn geliÅmiÅ NLP Ãķzelliklerini uygulamasÄąnÄą kolaylaÅtÄąrÄąrken, kapsamlÄą ÃķzelleÅtirme seçenekleri deneyimli ML mÞhendislerinin ihtiyaçlarÄąnÄą karÅÄąlar.

Hugging Face'i çevreleyen canlÄą topluluk, yaygÄąn sorunlara yÃķnelik çÃķzÞmlerin genellikle sadece bir forum aramasÄą uzaÄÄąnÄązda olmasÄą anlamÄąna gelir ve bu da geliÅtirme sÞresini Ãķnemli ÃķlçÞde azaltÄąr. Model Hub'da artÄąk 75.000'den fazla Ãķnceden eÄitilmiÅ model mevcut olduÄundan, geliÅtiriciler genellikle sÄąfÄąrdan baÅlamadan kullanÄąm durumu gereksinimlerine yakÄąn olan Ãķzel modeller bulabilirler.

Ä°deal KullanÄąm Ãrnekleri

Hugging Face Transformers 6.0 Åunlar için mÞkemmeldir:

FarklÄą model mimarileriyle hÄązlÄą denemeler gerektiren araÅtÄąrma projeleri

En son dil anlayÄąÅÄąna ihtiyaç duyan Þretim uygulamalarÄą

Topluluk bilgisinden ve kaynaklarÄąndan yararlanmak isteyen ekipler

Ãzel alan bilgisi (saÄlÄąk, hukuk, finans) gerektiren projeler

Ãok modlu yeteneklere ihtiyaç duyan uygulamalar

Dikkat Edilmesi Gerekenler

Transformers en çok yÃķnlÞ seçenek olmaya devam ederken, daÄÄątÄąm için her zaman en kaynak aÃ§ÄąsÄąndan verimli seçenek deÄildir. BazÄą geliÅtiriciler, genelleÅtirilmiÅ mimarinin, Ãķzel kÞtÞphanelerin kaÃ§ÄąndÄąÄÄą ek yÞk getirdiÄini bildiriyor. Ek olarak, hÄązla geliÅen kod tabanÄą, bÞyÞk sÞrÞmler arasÄąnda ara sÄąra bozucu deÄiÅiklikler anlamÄąna gelir.

2. SpaCy 4.0: Ãretime HazÄąr Verimlilik

Temel Ãzellikler ve Ä°yileÅtirmeler

SpaCy 4.0 masaya Ãķnemli geliÅtirmeler getiriyor:

DÃķnÞÅtÞrÞcÞ Entegrasyonu: GÞncellenen dÃķnÞÅtÞrÞcÞ boru hattÄą bileÅenleri artÄąk SpaCy'nin verimli iÅleme mimarisini korurken en son modellerle yerel olarak çalÄąÅÄąyor.

GeliÅmiÅ Ãoklu Ä°Åleme: Yeni paralel iÅleme yetenekleri, belge iÅleme gÃķrevleri için neredeyse doÄrusal Ãķlçekleme saÄlayarak SpaCy'yi muazzam metin koleksiyonlarÄąnÄą toplu iÅleme için uygun hale getiriyor.

GeniÅletilmiÅ YapÄąlandÄąrÄąlmÄąÅ Tahmin: AdlandÄąrÄąlmÄąÅ varlÄąk tanÄąma ve baÄÄąmlÄąlÄąk ayrÄąÅtÄąrmanÄąn Ãķtesinde, SpaCy artÄąk daha esnek bir aÃ§Äąklama ve eÄitim çerçevesi aracÄąlÄąÄÄąyla Ãķzel yapÄąlandÄąrÄąlmÄąÅ tahmin gÃķrevleri için geliÅmiÅ destek sunuyor.

Daha YalÄąn ÃalÄąÅma ZamanÄą Gereksinimleri: ArttÄąrÄąlmÄąÅ yeteneklere raÄmen, çekirdek iÅleme hatlarÄą artÄąk Ãķnemli ÃķlçÞde azaltÄąlmÄąÅ bellek ayak izleriyle çalÄąÅabilir; bu, kaynak kÄąsÄątlÄą ortamlarda daÄÄątÄąm için çok Ãķnemlidir.

GeliÅtirilmiÅ Kural Motoru: Desen eÅleÅtirme sistemi tamamen elden geçirilerek, eÅleÅtirme hÄązÄąnÄą %300'e kadar artÄąrÄąrken daha gÞçlÞ ifadeler sunar.

GeliÅtiricilerin Neden Bunu SeçtiÄi

SpaCy, geliÅtirici dostu bir API ile endÞstriyel dÞzeyde performans saÄladÄąÄÄą için Þretim sistemleri için tercih edilen seçenek olmaya devam ediyor. Ãzenle tasarlanmÄąÅ nesne odaklÄą mimari, tutarlÄą performansÄą korurken daha bÞyÞk uygulamalara entegre edilmesini kolaylaÅtÄąrÄąr.

Yeni "SpaCy Projeleri" çerçevesi ayrÄąca uçtan uca NLP hatlarÄąnÄąn paketlenmesini ve daÄÄątÄąmÄąnÄą basitleÅtirerek ekiplerin geliÅtirme iÅ akÄąÅlarÄąnÄą deneylerden Þretime kadar standartlaÅtÄąrmalarÄąna olanak tanÄąr.

Ä°deal KullanÄąm Ãrnekleri

SpaCy 4.0 Åunlar için mÞkemmeldir:

YÞksek verimli metin iÅleme sistemleri

GÞvenilirlik ve ÃķngÃķrÞlebilirliÄin kritik Ãķneme sahip olduÄu Þretim ortamlarÄą

EndÞstriyel gÞçte adlandÄąrÄąlmÄąÅ varlÄąk tanÄąma ve iliÅki Ã§Äąkarma gerektiren uygulamalar

DaÄÄątÄąm kÄąsÄątlamalarÄą (bellek, iÅlem gÞcÞ) olan projeler

Hem klasik NLP yeteneklerine hem de modern sinirsel yaklaÅÄąmlara ihtiyaç duyan ekipler

Dikkat Edilmesi Gerekenler

SpaCy, dÃķnÞÅtÞrÞcÞ modelleri dahil etmede bÞyÞk ilerlemeler kaydetmiÅ olsa da, Hugging Face ile aynÄą geniÅlikte son teknoloji araÅtÄąrma uygulamalarÄą sunmuyor. AyrÄąca, bazÄą geliÅtiriciler, onun inatÃ§Äą mimarisini son derece ÃķzelleÅtirilmiÅ araÅtÄąrma uygulamalarÄą için daha az esnek buluyor.

3. Cohere SDK: API-First Dil ZekasÄą

Temel Ãzellikler ve Ä°yileÅtirmeler

Cohere platformu birkaç ilgi çekici yetenek sunar:

Komut ve Komut-R Modelleri: Bu modeller belirli talimatlarÄą izleme ve ayrÄąntÄąlÄą istekleri anlama konusunda mÞkemmeldir ve bu da onlarÄą kullanÄącÄą sorgularÄąna tam olarak yanÄąt veren araçlar oluÅturmak için ideal hale getirir.

GÃķmÞlÞ Modeller: En son nesil gÃķmme modelleri, alma ve sÄąnÄąflandÄąrma gÃķrevlerinde Ãķnceki yaklaÅÄąmlardan Ãķnemli ÃķlçÞde daha iyi performans gÃķstererek dikkat çekici derecede doÄru semantik temsiller oluÅturur.

Kurumsal ÃzelleÅtirme: Belirli ihtiyaçlarÄą olan kuruluÅlar için Cohere artÄąk bÞyÞk eÄitim veri kÞmeleri gerektirmeden temel modellerini uzmanlaÅmÄąÅ alanlara uyarlayan ÃķzelleÅtirme seçenekleri sunuyor.

Ãok Dilli Destek: 100'den fazla dilde saÄlam yetenekler, her dil için ayrÄą modellere ihtiyaç duymadan kÞresel uygulamalarÄą etkinleÅtirir.

Sorumlu AI Kontrolleri: Dahili gÞvenlik filtreleri ve ÃķnyargÄą tespiti, geliÅtiricilerin giderek daha Ãķnemli hale gelen etik standartlarÄą karÅÄąlayan sistemler oluÅturmasÄąna yardÄąmcÄą olur.

GeliÅtiriciler Neden Bunu Seçiyor

Cohere SDK, Ãķncelikle karmaÅÄąk NLP yeteneklerini uygulamadaki engelleri Ãķnemli ÃķlçÞde azalttÄąÄÄą için ilgi gÃķrdÞ. Makine ÃķÄrenimi uzmanlÄąÄÄą olmayan geliÅtiriciler, gerektiÄinde model davranÄąÅÄą Þzerinde ayrÄąntÄąlÄą kontrole sahipken, minimum kodla uygulamalara geliÅmiÅ dil anlayÄąÅÄą ekleyebilirler.

API Ãķncelikli yaklaÅÄąm ayrÄąca ekiplerin altyapÄą yÃķnetimi veya en son araÅtÄąrma geliÅmelerini takip etme konusunda endiÅelenmelerine gerek olmadÄąÄÄą anlamÄąna gelir; Cohere bu yÃķnleri ele alarak geliÅtiricilerin uygulama mantÄąÄÄąna odaklanmalarÄąnÄą saÄlar.

Ä°deal KullanÄąm Ãrnekleri

Cohere SDK Åunlar için mÞkemmeldir:

Ãzel ML altyapÄąsÄą olmayan yeni baÅlayanlar ve ekipler

Model daÄÄątÄąmÄąnÄą yÃķnetmeden hÄązlÄą bir Åekilde Ãķlçeklenmesi gereken uygulamalar

Kurumsal dÞzeyde gÞvenilirlik ve destek gerektiren projeler

KÞresel pazarlara hizmet eden çok dilli uygulamalar

Sorumlu AI uygulamalarÄąnÄąn Ãķncelik olduÄu kullanÄąm Ãķrnekleri

Dikkat Edilmesi Gerekenler

Cohere ile ilgili temel dezavantaj, geliÅtiricilerin modelleri kendi altyapÄąlarÄąnda çalÄąÅtÄąrmak yerine ÞçÞncÞ taraf bir hizmete baÄÄąmlÄą olmalarÄądÄąr. Bu, veri gizliliÄi, hizmet kullanÄąlabilirliÄi ve uzun vadeli fiyatlandÄąrma istikrarÄą konusunda potansiyel endiÅeler yaratÄąr. BazÄą geliÅtiriciler ayrÄąca, API tabanlÄą yaklaÅÄąmÄąn kullanÄąÅlÄą olmasÄąna raÄmen, bazen doÄrudan model iç bileÅenlerine eriÅime kÄąyasla esnekliÄi sÄąnÄąrladÄąÄÄąnÄą da belirtmektedir.

4. PyTorch NLP (torchtext 3.0): AraÅtÄąrmacÄąnÄąn Seçimi

Temel Ãzellikler ve Ä°yileÅtirmeler

En son sÞrÞm birkaç Ãķnemli yÞkseltme getiriyor:

TransformatÃķr Mimarileri için Yerel Destek: Dikkat mekanizmalarÄąnÄąn ve transformatÃķr bloklarÄąnÄąn birinci sÄąnÄąf uygulamalarÄą, Ãķzel mimarileri uygulamayÄą kolaylaÅtÄąrÄąr.

Optimize EdilmiÅ Veri Ä°Åleme Boru HatlarÄą: Yeni vektÃķrleÅtirilmiÅ metin iÅleme iÅlemleri, modern CPU'larÄą ve GPU'larÄą daha etkili bir Åekilde kullanarak Ãķn iÅleme adÄąmlarÄąnÄą Ãķnemli ÃķlçÞde hÄązlandÄąrÄąr.

GeliÅmiÅ Transfer ÃÄrenme Ãerçevesi: Ä°yileÅtirilmiÅ API, eÄitim sÞreci Þzerinde hassas kontrolÞ korurken Ãķnceden eÄitilmiÅ modelleri yeni gÃķrevlere uyarlamayÄą kolaylaÅtÄąrÄąr.

Nicemleme ve Budama AraçlarÄą: Model sÄąkÄąÅtÄąrma için yerleÅik Ãķzellikler, araÅtÄąrmacÄąlarÄąn aÅÄąrÄą performans dÞÅÞÅÞ olmadan model boyutunu ve Ã§ÄąkarÄąm sÞresini azaltmasÄąnÄą saÄlar.

GeliÅtirilmiÅ Toplu Ä°Åleme: DeÄiÅken uzunluktaki diziler için daha akÄąllÄą toplu iÅleme stratejileri, eÄitim sÄąrasÄąnda daha verimli GPU kullanÄąmÄąyla sonuçlanÄąr.

AraÅtÄąrmacÄąlar ve GeliÅtiriciler Neden Bunu Seçiyor

PyTorch NLP, kullanÄąlabilirlikten ÃķdÞn vermeden maksimum esneklik sunduÄu için araÅtÄąrma ve uzmanlaÅmÄąÅ uygulamalar için tercih edilen seçenek olmaya devam ediyor. Zorunlu programlama stili, çoÄu geliÅtiricinin dÞÅÞnme biçimiyle uyumludur ve modelleri hata ayÄąklamayÄą ve yeni yaklaÅÄąmlarla denemeler yapmayÄą kolaylaÅtÄąrÄąr.

Daha geniÅ PyTorch ekosistemiyle kusursuz entegrasyon, genel derin ÃķÄrenmedeki geliÅmelerin (optimizasyon teknikleri veya eÄitim yÃķntemleri gibi) NLP gÃķrevlerine hemen uygulanabilir olduÄu anlamÄąna da gelir.

Ä°deal KullanÄąm Ãrnekleri

PyTorch NLP Åunlar için en uygunudur:

Yeni mimarileri veya eÄitim yaklaÅÄąmlarÄąnÄą inceleyen araÅtÄąrma projeleri

Daha Þst dÞzey kÞtÞphanelerde bulunmayan ÃķzelleÅtirilmiÅ model davranÄąÅÄą gerektiren uygulamalar

Model iç yapÄąsÄąnÄą anlamanÄąn Ãķnemli olduÄu eÄitim baÄlamlarÄą

BilgisayarlÄą gÃķrÞŠveya diÄer yÃķntemlerle entegrasyonun gerekli olduÄu projeler

EÄitim sÞreci Þzerinde maksimum kontrol gerektiren durumlar

Dikkat Edilmesi Gerekenler

PyTorch NLP'nin esnekliÄi daha dik bir ÃķÄrenme eÄrisi ve daha fazla uygulama sorumluluÄu ile birlikte gelir. GeliÅtiricilerin daha Þst dÞzey kÞtÞphanelere kÄąyasla daha fazla mimari karar almasÄą ve sÄąfÄąrdan daha fazla bileÅen uygulamasÄą gerekir. Ek olarak, bazÄą Þretim optimizasyonu Ãķzelliklerinin dÞzgÞn bir Åekilde uygulanmasÄą için ek çalÄąÅma gerekir.

SÄ°ZÄ°N web sitenizde yapay zekayÄą 60 saniyede

Yapay zekamÄązÄąn web sitenizi anÄąnda nasÄąl analiz ettiÄini ve kiÅiselleÅtirilmiÅ bir sohbet robotu oluÅturduÄunu gÃķrÞn - kayÄąt olmadan. Sadece URL'nizi girin ve nasÄąl çalÄąÅtÄąÄÄąnÄą izleyin!

5. JAX NLP (FLAX/Prax): Ãlçekte Performans

Meta Description: Discover the most powerful and versatile natural language processing libraries of 2025 that are revolutionizing how developers build intelligent text applications.

Introduction: The Evolving Landscape of NLP Development

Natural Language Processing (NLP) continues to transform how we interact with technology in 2025. As the demand for sophisticated language understanding capabilities grows across industries, developers need powerful, efficient, and accessible tools to build applications that can genuinely understand and generate human language.

The past year has seen remarkable advancements in NLP technologyâfrom more efficient fine-tuning approaches to multimodal capabilities that bridge text with other data types. Runtime efficiency has become increasingly important as more NLP workloads move to edge devices and consumer hardware. Meanwhile, specialized domain capabilities have expanded to serve industries from healthcare to legal services with unprecedented accuracy.

Whether you're building a conversational agent, analyzing customer feedback, extracting insights from documents, or creating content generation tools, choosing the right NLP library can dramatically impact your project's success. This guide examines the seven most impactful NLP libraries of 2025, comparing their strengths, limitations, and ideal use cases to help you make an informed decision for your next development project.

1. Hugging Face Transformers 6.0: The Comprehensive Ecosystem

Hugging Face Transformers has cemented its position as the go-to library for accessing state-of-the-art NLP models, and the 6.0 release takes its capabilities to new heights. Far more than just a model repository, Transformers has evolved into a comprehensive ecosystem that covers the entire NLP development lifecycle.

Key Features and Improvements

The latest version introduces several game-changing features:

Efficient Fine-tuning Framework: The new EFT module significantly reduces the computational requirements for adapting foundation models to specific tasks. Models that previously required multiple GPUs for fine-tuning can now be customized on consumer hardware with minimal performance trade-offs.

Multimodal Pipelines: Transformers now offers streamlined pipelines for building applications that seamlessly combine text analysis with image, audio, and even video understandingâperfect for creating more context-aware applications.

Enterprise-Grade Deployment Tools: The new deployment toolkit simplifies moving models from research to production with automated optimization for different hardware targets, from server clusters to mobile devices.

Domain Specialization Packs: Pre-configured settings and models for specific industries like healthcare, legal, and finance allow developers to start with domain-optimized foundations rather than generic models.

Why Developers Love It

Transformers continues to dominate because it strikes an exceptional balance between accessibility and cutting-edge capabilities. The well-documented API makes it straightforward for newcomers to implement advanced NLP features, while the extensive customization options satisfy the needs of experienced ML engineers.

The vibrant community surrounding Hugging Face also means solutions to common problems are usually just a forum search away, significantly reducing development time. With over 75,000 pre-trained models now available in the Model Hub, developers can often find specialized models that closely match their use case requirements without starting from scratch.

Ideal Use Cases

Hugging Face Transformers 6.0 excels for:

Research projects requiring quick experimentation with different model architectures

Production applications needing state-of-the-art language understanding

Teams wanting to leverage community knowledge and resources

Projects requiring specialized domain knowledge (healthcare, legal, finance)

Applications needing multimodal capabilities

Considerations

While Transformers remains the most versatile option, it's not always the most resource-efficient choice for deployment. Some developers report that the generalized architecture introduces overhead that specialized libraries avoid. Additionally, the rapidly evolving codebase means occasional breaking changes between major versions.

2. SpaCy 4.0: Production-Ready Efficiency

SpaCy has long been the workhorse of production NLP systems, and version 4.0 reinforces this position while expanding its capabilities to incorporate transformer-based models more seamlessly than ever. The library's focus on production efficiency combined with state-of-the-art accuracy makes it ideal for systems that need reliability at scale.

Key Features and Improvements

SpaCy 4.0 brings significant enhancements to the table:

Transformer Integration: The updated transformer pipeline components now work natively with the latest models while maintaining SpaCy's efficient processing architecture.

Enhanced Multiprocessing: New parallel processing capabilities provide near-linear scaling for document processing tasks, making SpaCy suitable for batch processing enormous text collections.

Expanded Structured Prediction: Beyond named entity recognition and dependency parsing, SpaCy now offers enhanced support for custom structured prediction tasks through a more flexible annotation and training framework.

Leaner Runtime Requirements: Despite the increased capabilities, core processing pipelines can now run with significantly reduced memory footprintsâcrucial for deployment in resource-constrained environments.

Improved Rule Engine: The pattern matching system has been completely overhauled, offering more powerful expressions while improving match speed by up to 300%.

Why Developers Choose It

SpaCy continues to be the preferred choice for production systems because it provides industrial-strength performance with a developer-friendly API. The thoughtfully designed object-oriented architecture makes it easy to integrate into larger applications while maintaining consistent performance.

The new "SpaCy Projects" framework has also simplified the packaging and deployment of end-to-end NLP pipelines, allowing teams to standardize their development workflows from experimentation to production.

Ideal Use Cases

SpaCy 4.0 is perfect for:

High-throughput text processing systems

Production environments where reliability and predictability are crucial

Applications requiring industrial-strength named entity recognition and relation extraction

Projects with deployment constraints (memory, processing power)

Teams that need both classical NLP capabilities and modern neural approaches

Considerations

While SpaCy has made great strides in incorporating transformer models, it still doesn't offer the same breadth of cutting-edge research implementations as Hugging Face. Additionally, some developers find its opinionated architecture less flexible for highly customized research applications.

3. Cohere SDK: API-First Language Intelligence

Cohere has emerged as a powerful alternative in the NLP ecosystem with its SDK that focuses on delivering production-ready language intelligence through a streamlined API. Rather than requiring developers to manage model deployment themselves, Cohere provides access to continuously updated, state-of-the-art models via simple API calls.

Key Features and Improvements

The Cohere platform offers several compelling capabilities:

Command and Command-R Models: These models excel at following specific instructions and understanding nuanced requests, making them ideal for building tools that respond precisely to user queries.

Embed Models: The latest generation embedding models create remarkably accurate semantic representations, significantly outperforming previous approaches in retrieval and classification tasks.

Enterprise Customization: For organizations with specific needs, Cohere now offers customization options that adapt their core models to specialized domains without requiring massive training datasets.

Multilingual Support: Robust capabilities across 100+ languages enable global applications without needing separate models for each language.

Responsible AI Controls: Built-in safety filters and bias detection help developers create systems that meet increasingly important ethical standards.

Why Developers Choose It

The Cohere SDK has gained traction primarily because it dramatically lowers the barrier to implementing sophisticated NLP capabilities. Developers without machine learning expertise can add advanced language understanding to applications with minimal code, while still having fine-grained control over the model behavior when needed.

The API-first approach also means teams don't need to worry about infrastructure management or keeping up with the latest research advancementsâCohere handles these aspects, allowing developers to focus on their application logic.

Ideal Use Cases

Cohere SDK is excellent for:

Startups and teams without dedicated ML infrastructure

Applications that need to scale quickly without managing model deployment

Projects requiring enterprise-grade reliability and support

Multi-language applications serving global markets

Use cases where responsible AI practices are a priority

Considerations

The primary tradeoff with Cohere is that developers are depending on a third-party service rather than running models in their own infrastructure. This creates potential concerns around data privacy, service availability, and long-term pricing stability. Some developers also note that the API-based approach, while convenient, sometimes limits flexibility compared to having direct access to model internals.

4. PyTorch NLP (torchtext 3.0): The Researcher's Choice

For researchers and developers who prefer working closer to the metal, PyTorch's ecosystem continues to offer unparalleled flexibility. The overhauled torchtext 3.0 has evolved from a collection of utilities into a comprehensive NLP framework while maintaining the flexibility that PyTorch users value.

Key Features and Improvements

The latest version brings several significant upgrades:

Native Support for Transformer Architectures: First-class implementations of attention mechanisms and transformer blocks make it easier to implement custom architectures.

Optimized Data Processing Pipelines: New vectorized text processing operations leverage modern CPUs and GPUs more effectively, dramatically speeding up preprocessing steps.

Enhanced Transfer Learning Framework: The refined API makes it straightforward to adapt pre-trained models to new tasks while maintaining precise control over the training process.

Quantization and Pruning Tools: Built-in capabilities for model compression enable researchers to reduce model size and inference time without excessive performance degradation.

Improved Batch Processing: Smarter batching strategies for variable-length sequences result in more efficient GPU utilization during training.

Why Researchers and Developers Choose It

PyTorch NLP remains the preferred choice for research and specialized applications because it offers maximum flexibility without sacrificing usability. The imperative programming style aligns with how most developers think, making it easier to debug models and experiment with novel approaches.

The seamless integration with the broader PyTorch ecosystem also means that advancements in general deep learning (like optimization techniques or training methods) are immediately applicable to NLP tasks.

Ideal Use Cases

PyTorch NLP is best suited for:

Research projects exploring novel architectures or training approaches

Applications requiring customized model behavior not available in higher-level libraries

Educational contexts where understanding model internals is important

Projects where integration with computer vision or other modalities is needed

Situations requiring maximal control over the training process

Considerations

The flexibility of PyTorch NLP comes with a steeper learning curve and more implementation responsibility. Developers need to make more architectural decisions and implement more components from scratch compared to higher-level libraries. Additionally, some production optimization features require additional work to implement properly.

5. JAX NLP (FLAX/Prax): Performance at Scale

JAX has established itself as the framework of choice for training and deploying extremely large language models, and its NLP ecosystem has matured significantly. The FLAX and Prax libraries built on JAX offer unprecedented performance for large-scale NLP workloads while maintaining a reasonable developer experience.

Key Features and Improvements

JAX's NLP ecosystem offers several distinctive advantages:

Transparent XLA Compilation: Automatic optimization for TPUs, GPUs, and specialized hardware delivers remarkable training and inference speed improvements.

Functional Programming Model: The pure functional approach simplifies distribution across multiple devices and helps avoid subtle training bugs.

Advanced Parallelism: Built-in support for model, data, and pipeline parallelism makes training massive models more accessible.

Hardware-Specific Optimizations: Specialized implementations take full advantage of the latest accelerator features from different hardware vendors.

Differential Privacy Integration: Built-in support for private training methods addresses growing regulatory requirements around data privacy.

Why Teams Choose It

Organizations working with extremely large models or datasets choose JAX-based solutions primarily for the performance benefits. Models that would take weeks to train on other frameworks can often be completed in days with JAX, representing significant cost savings in cloud compute resources.

The functional approach also brings benefits for reproducibility and debugging, which become increasingly important as models grow in complexity and training runs become more expensive.

Ideal Use Cases

JAX NLP is ideal for:

Training and deploying very large language models

Organizations with access to specialized hardware (TPUs, etc.)

Projects requiring maximum computational efficiency

Situations where reproducibility is critical

Applications demanding rigorous privacy guarantees

Considerations

JAX's programming model, while powerful, represents a significant departure from the more familiar object-oriented approaches of other frameworks. This can increase the initial learning curve, particularly for developers without a strong functional programming background. Additionally, while the ecosystem is growing rapidly, it still has fewer ready-to-use components than more established frameworks.

6. TensorFlow Text 3.0: Kurumsal Ä°stikrar

Temel Ãzellikler ve Ä°yileÅtirmeler

TensorFlow Text 3.0 birkaç Ãķnemli iyileÅtirme sunuyor:

TF Extended ile Entegrasyon: TensorFlow'un Þretim ML boru hattÄą araçlarÄąyla sorunsuz baÄlantÄą, deneylerden daÄÄątÄąma kadar olan yolculuÄu basitleÅtiriyor.

GeliÅmiÅ TFLite DesteÄi: TFLite'taki iyileÅtirilmiÅ metin iÅleme iÅlemleri, NLP modellerini mobil ve uç cihazlara daÄÄątmayÄą daha pratik hale getiriyor.

TutarlÄą Platformlar ArasÄą Deneyim: AynÄą modeller ve iÅleme boru hatlarÄą, bulut TPU'larÄąndan mobil cihazlara kadar eÄitim ve Ã§ÄąkarÄąm ortamlarÄąnda gÞvenilir bir Åekilde çalÄąÅÄąyor.

GeniÅletilmiÅ Kurumsal Entegrasyon: Ortak kurumsal veri kaynaklarÄą için yerel baÄlayÄącÄąlar, metin iÅlemeyi mevcut iÅ akÄąÅlarÄąna dahil etmeyi basitleÅtiriyor.

KapsamlÄą Hizmet Seçenekleri: TF Serving'den SavedModel'e ve TFLite'a kadar daÄÄątÄąm seçenekleri hemen hemen her hedef ortamÄą kapsar.

KuruluÅlarÄąn Neden Bunu SeçtiÄi

TensorFlow Text, veri hazÄąrlamadan daÄÄątÄąma kadar eksiksiz bir çÃķzÞm sunduÄu için kurumsal ortamlarda popÞlerliÄini sÞrdÞrÞyor. API'nin kararlÄąlÄąÄÄą ve kapsamlÄą daÄÄątÄąm seçenekleri, NLP'yi kritik Ãķneme sahip uygulamalara dahil etmeyle iliÅkili riski azaltÄąr.

Google'Äąn bulut teklifleriyle entegrasyon, bu ekosisteme halihazÄąrda yatÄąrÄąm yapmÄąÅ kuruluÅlar için basit bir Ãķlçekleme yolu da saÄlar.

Ä°deal KullanÄąm Ãrnekleri

TensorFlow Text 3.0 Åunlar için mÞkemmeldir:

Ãretim kararlÄąlÄąÄÄą gerektiren kurumsal uygulamalar

Mobil ve uç daÄÄątÄąm senaryolarÄą

Mevcut TensorFlow yatÄąrÄąmlarÄą olan kuruluÅlar

KapsamlÄą ML hatlarÄąna ihtiyaç duyan projeler

DaÄÄątÄąm esnekliÄinin Ãķnemli olduÄu uygulamalar

Dikkat Edilmesi Gerekenler

TensorFlow Text yeni Ãķzellikler eklemeye devam ederken, bazen en son araÅtÄąrma geliÅmelerini uygulamada diÄer çerçevelerin gerisinde kalmaktadÄąr. AyrÄąca bazÄą geliÅtiriciler, sembolik programlama modelini PyTorch'un zorunlu yaklaÅÄąmÄąna kÄąyasla deneme amaçlÄą daha az sezgisel bulmaktadÄąr.

7. Flair 2.0: NLP Ä°sviçre ÃakÄąsÄą

Temel Ãzellikler ve Ä°yileÅtirmeler

Flair 2.0, birkaç Ãķnemli iyileÅtirme getiriyor:

Hibrit GÃķmme Ãerçevesi: Belirli gÃķrevler için en iyi performansÄą elde etmek Þzere farklÄą gÃķmme tÞrlerini (baÄlamsal, statik, karakter dÞzeyinde) kolayca birleÅtirin.

Tek Seferlik ÃÄrenme Yetenekleri: Yeni birkaç seferlik ÃķÄrenme teknikleri, minimum etiketli veriyle uzmanlaÅmÄąÅ gÃķrevlerde ÅaÅÄąrtÄącÄą derecede iyi sonuçlar sunar.

GeliÅmiÅ Belge ZekasÄą: GeliÅmiÅ belge modelleme yaklaÅÄąmlarÄą, uzun metinlerdeki uzun menzilli baÄÄąmlÄąlÄąklarÄą daha iyi yakalar.

BasitleÅtirilmiÅ Ä°nce Ayar: Ãnceden eÄitilmiÅ modelleri belirli alanlara veya gÃķrevlere uyarlamak için basitleÅtirilmiÅ iÅ akÄąÅlarÄą.

Daha Hafif Kaynak Gereksinimleri: GeliÅmiÅ verimlilik, Flair'i daha az gÞçlÞ donanÄąmlarda daÄÄątÄąm için uygun hale getirir.

GeliÅtiriciler Neden Bunu Seçiyor?

Flair, gÞç ve basitlik arasÄąnda mÞkemmel bir denge kurduÄu için sadÄąk bir takipçi kitlesi kazandÄą. KÞtÞphane, daha aÄÄąr çerçevelerden Ãķnemli ÃķlçÞde daha az kod ve hesaplama kaynaÄÄą gerektirirken birçok yaygÄąn NLP gÃķrevi için neredeyse son teknoloji performans sunar.

Sezgisel API tasarÄąmÄą, NLP uzmanÄą olmayan geliÅtiriciler için de eriÅilebilir hale getirerek, nispeten yumuÅak bir ÃķÄrenme eÄrisiyle uygulamalarÄąna geliÅmiÅ dil anlayÄąÅÄąnÄą dahil etmelerine olanak tanÄąr.

Ä°deal KullanÄąm Ãrnekleri

Flair 2.0 Åunlar için en iyi Åekilde çalÄąÅÄąr:

MÞkemmel dizi etiketleme (NER, POS etiketleme) gerektiren projeler

SÄąnÄąrlÄą hesaplama kaynaklarÄąna sahip uygulamalar

Standart NLP gÃķrevlerinin hÄązlÄą uygulanmasÄąnÄą arayan ekipler

Minimum etiketli eÄitim verilerine sahip senaryolar

Ãzel metin sÄąnÄąflandÄąrma uygulamalarÄą

Dikkat Edilmesi Gerekenler

Flair yeteneklerini geniÅletmeye devam ederken, Hugging Face Transformers gibi daha bÞyÞk çerçevelerle aynÄą model ve teknik geniÅliÄini sunmuyor. AyrÄąca bazÄą geliÅtiriciler, dokÞmantasyonun geliÅmesine raÄmen, daha kÃķklÞ kÞtÞphanelerde bulunan kapsamlÄą Ãķrneklerden hÃĒlÃĒ yoksun olduÄunu belirtiyor.

Sonuç: Ä°htiyaçlarÄąnÄąza Uygun DoÄru NLP KÞtÞphanesini Seçmek

Hugging Face Transformers 6.0 en kapsamlÄą ekosistemi ve model seçimini sunuyor

SpaCy 4.0 endÞstriyel gÞçte performans ve Þretim gÞvenilirliÄi sunuyor

Cohere SDK sÞrekli gÞncellenen modellerle API Ãķncelikli kolaylÄąk sunuyor

PyTorch NLP araÅtÄąrmacÄąlara maksimum esneklik ve kontrol saÄlÄąyor

JAX NLP bÞyÞk Ãķlçekli uygulamalar için eÅsiz performans sunuyor

TensorFlow Text 3.0 kurumsal istikrar ve daÄÄątÄąm seçenekleri sunuyor

Flair 2.0 etkileyici yetenekleri hafif bir pakette birleÅtiriyor

DoÄru seçim, Ãķzel gereksinimlerinize baÄlÄądÄąr:

HÄązlÄą prototipleme ve son teknoloji modellere eriÅim için Hugging Face Transformers'Äą yenmek zor olmaya devam ediyor. Ãretim gÞvenilirliÄi ve verimliliÄi sizin için Ãķncelikli endiÅelerse, SpaCy mÞkemmelliÄini sÞrdÞrÞyor. GeliÅtirme hÄązÄą ve uygulama kolaylÄąÄÄą en Ãķnemli olduÄunda, Cohere'nin API Ãķncelikli yaklaÅÄąmÄą ikna edici avantajlar sunar.

Maksimum esneklik gerektiren araÅtÄąrmacÄąlar yine de PyTorch NLP'ye yÃķnelirken, bÞyÞk modeller eÄiten kuruluÅlar JAX'Äąn performans optimizasyonlarÄąndan faydalanacaktÄąr. Ä°stikrarÄą ve kapsamlÄą daÄÄątÄąm seçeneklerini Ãķnemseyen kuruluÅlar TensorFlow Text'i gÞvenli bir seçim olarak gÃķrÞrken, etkileyici yeteneklere sahip hafif bir çÃķzÞm arayan ekipler Flair'Äą deÄerlendirmelidir.

NLP teknolojisi dikkat çekici bir hÄązla geliÅmeye devam ederken, bu kÞtÞphanelerin yetenekleri ve geliÅtirme eÄilimleri hakkÄąnda bilgi sahibi olmak, projeleriniz için en iyi seçimi yapmanÄąza ve uygulamalarÄąnÄązÄą en son teknolojiye sahip tutmanÄąza yardÄąmcÄą olacaktÄąr.

Bir sonraki NLP projeniz nedir ve bu kÞtÞphanelerden hangisi Ãķzel gereksinimleriniz için mÞkemmel uyum saÄlayabilir?